Wenn Sie KI-Nachrichten oder sogar Technologienachrichten verfolgen, haben Sie vielleicht schon von DeepSeek gehört, dem leistungsstarken chinesischen Großsprachenmodell, das über Fähigkeiten verfügt, die mit ChatGPT mithalten können, und gleichzeitig deutlich geringere Schulungskosten aufweist. DeepSeek ist für fortgeschrittenes Denken konzipiert und verfügt über allgemeine natürliche Sprach- und ChatBot-Fähigkeiten, Aufgabenkompetenz und Recherche. Darüber hinaus eignet es sich hervorragend für Codierung, Codegenerierung und Logik, was es zu einem leistungsstarken KI-Tool im Allgemeinen und möglicherweise für Ihren Arbeitsablauf macht. Während Sie DeepSeek überall im Internet ausführen können und DeepSeek mithilfe der DeepSeek Cloud auch über eine App auf Ihrem iPhone oder iPad herunterladen und ausführen können, steht Mac-Benutzern eine weitere Option zur Verfügung. Führen Sie DeepSeek LLM lokal auf Ihrem Mac aus.

Die lokale Ausführung von DeepSeek kann für viele Mac-Benutzer nützlich sein, unabhängig davon, ob Sie Entwickler, Forscher oder einfach nur neugierig auf die Erforschung von KI- und LLM-Dienstprogrammen sind. Einer der bedeutendsten Vorteile der lokalen Nutzung und Ausführung von DeepSeek besteht darin, dass es offline ist, sodass Sie die Vorteile von DeepSeek LLM nutzen können, ohne auf Cloud-Dienste angewiesen zu sein (die mit China verbunden sind, was auch immer Sie daraus machen), und mehr Privatsphäre und potenzielle Freiheit bieten, das Modell an Ihre speziellen Anwendungsfälle anzupassen und zu verfeinern.

Sie benötigen einen Apple Silicon Mac, um DeepSeek lokal ausführen zu können. In diesem Fall verwenden wir ein kostenloses Tool für Mac namens LM Studio, um DeepSeek schnell auf einem Mac einrichten und verwenden zu können. Auch wenn sich das alles kompliziert anhört und die KI- und LLM-Technologie für Neueinsteiger überwältigend sein kann, ist dieser Einrichtungsprozess wirklich recht einfach, da wir Sie durch ihn führen.

Auch hier müssen Sie einen Apple Silicon Mac mit einem Chip der M-Serie oder besser haben, um DeepSeek lokal ausführen zu können. Obwohl diese Softwareanforderung streng ist, ist sie auch bei der Ausführung jedes anderen lokalen Modells Standard, einschließlich Apple Intelligence, ChatGPT, Llama oder einem der anderen zunehmend verbreiteten LLM-Tools. Sie benötigen außerdem mindestens 10 GB verfügbaren Speicherplatz. Wenn Sie keinen Apple Silicon Mac besitzen, können Sie KI-Tools dennoch über Ihr iPhone oder iPad mit verschiedenen Apps oder über jeden Mac über das Internet nutzen. Für unsere Zwecke hier gehen wir davon aus, dass Sie einen Apple Silicon Mac haben. In diesem Fall erfahren Sie hier, wie Sie DeekSeek lokal zum Laufen bringen:

- Holen Sie sich lmstudio kostenlos von lmstudio.ai

- Hängen Sie das Disk-Image für LMStudio ein und kopieren Sie die App „LM Studio“ vom Disk-Image in Ihren Anwendungsordner, um sie zu installieren. Starten Sie dann LM Studio direkt aus Ihrem Anwendungsordner

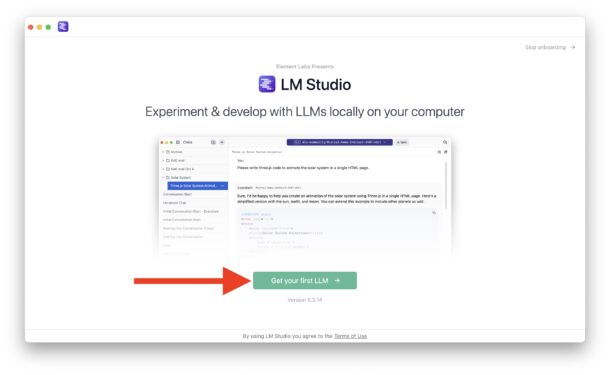

- Beim ersten Start wird Ihnen ein Onboarding-Begrüßungsbildschirm angezeigt. Klicken Sie auf die grüne Schaltfläche mit der Aufschrift „Holen Sie sich Ihr erstes LLM.“

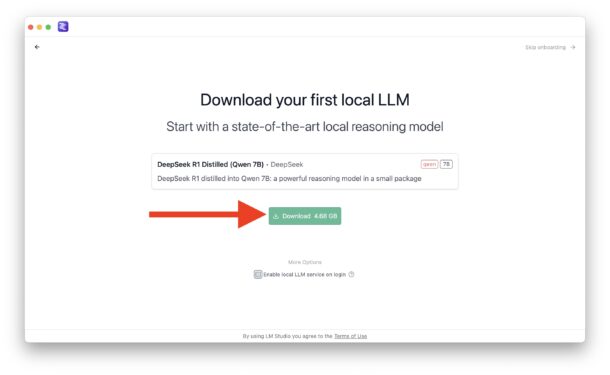

- Klicken Sie im Bildschirm „Laden Sie Ihr erstes lokales LLM herunter“ auf die grüne Schaltfläche „Herunterladen“ (optional deaktivieren Sie das Kontrollkästchen „Lokalen LLM-Dienst bei Anmeldung aktivieren“, wenn Sie nicht möchten, dass bei jedem Start Ihres Mac ein Daemon für DeekSeek ausgeführt wird).

- Lassen Sie DeekSeek LLM herunterladen, es ist mehrere GB groß und kann eine Weile dauern. Sobald DeekSeek lokal heruntergeladen wurde, können Sie direkt auf Ihrem Mac damit interagieren

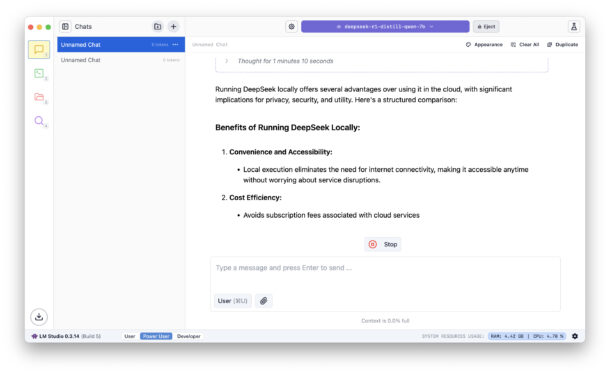

Jetzt können Sie DeekSeek lokal auf Ihrem Mac verwenden und damit interagieren.

Wenn Sie bestätigen möchten, dass Ihr Erlebnis ausschließlich lokal erfolgt, schalten Sie Ihr WLAN aus oder trennen Sie die Verbindung zum Internet. Sie werden sehen, dass Sie weiterhin nach Belieben mit LM Studio und DeekSeek interagieren können.

Sie werden wahrscheinlich feststellen, dass die lokale Ausführung eines LLM wahrscheinlich langsamer ist als die Verwendung eines Cloud-basierten LLM. Das liegt daran, dass Cloud-LLMs über große Mengen leistungsstarker Ressourcen verfügen, die ausschließlich für die Ausführung der Modelle bestimmt sind. Wenn Sie ein LLM lokal ausführen, wird dies jedoch durch die lokalen Ressourcen Ihres Mac begrenzt, einschließlich Ihres Prozessors, Speichers und was sonst noch auf Ihrem Mac ausgeführt wird. Wenn Sie ausschließlich an Geschwindigkeit und Leistung interessiert sind, möchten Sie wahrscheinlich stattdessen einen Cloud-Anbieter nutzen, obwohl die neuesten, leistungsstärksten Macs auch recht schnell sind.

Mehr lesen:Öffnen Sie immer lokal gespeicherte Office 365-Dateien anstelle von Cloud-Versionen

Sie können LM Studio auch auf dem Mac verwenden, um andere LLMs lokal auszuführen. Neben DeekSeek gehören dazu auch Llama, Mistral und Phi, aber wir konzentrieren uns hier natürlich auf DeepSeek. Wir haben in der Vergangenheit andere Optionen im Sinne lokaler Modelle diskutiert, einschließlich der lokalen Ausführung von Llama LLM auf dem Mac (einschließlich eines unzensierten Modells!), aber dieser Ansatz zur lokalen Ausführung von DeepSeek (und anderen LLMs, wenn Sie neugierig sind) ist wirklich recht einfach und die Leistung ist auch gut. DankCultOfMacfür die Inspiration.

Persönlich bin ich ein großer Fan des Mac-Clients für ChatGPT, den ich häufig verwende, aber es gibt auch Perplexity und viele andere interessante Clients und KI-Tools. Abgesehen von den Dutzenden web- oder app-basierten Optionen, darunter Bing mit ChatGPT, Google Gemini, X’s Grok, Facebook’s Llama und viele andere.

Was halten Sie davon, DeepSeek lokal auf Ihrem Mac auszuführen? Was halten Sie von LLM- und KI-Tools im Allgemeinen? Haben Sie ein bevorzugtes lokales LLM oder einen bevorzugten LLM-Kunden? Teilen Sie Ihre Gedanken und Erfahrungen mit DeekSeek, LLMs und KI im Allgemeinen in den Kommentaren!