Pokud sledujete zprávy o AI nebo dokonce technologické novinky, možná jste již slyšeli o DeepSeek, výkonném modelu čínského velkého jazyka, který má schopnosti konkurovat ChatGPT a zároveň má dramaticky nižší náklady na školení. DeepSeek je navržen pro pokročilé uvažování, s obecným přirozeným jazykem a schopnostmi ChatBota, kompetencí úkolů, výzkumem a zároveň je vynikající pro kódování, generování kódu a logiku, což z něj dělá výkonný nástroj AI obecně a potenciálně pro váš pracovní postup. Zatímco DeepSeek můžete spustit kdekoli na webu a také si můžete stáhnout a spustit DeepSeek prostřednictvím aplikace na vašem iPhone nebo iPadu pomocí DeepSeek Cloud, pro uživatele Macu je k dispozici další možnost; spuštění DeepSeek LLM lokálně na vašem Macu.

Lokální provoz DeepSeek může být užitečný pro mnoho uživatelů počítačů Mac, ať už jste vývojář, výzkumník nebo někdo, kdo je prostě zvědavý na prozkoumání nástrojů AI a LLM. Jednou z nejvýznamnějších výhod používání a spouštění DeepSeek lokálně je to, že je offline, což vám poskytuje výhody DeepSeek LLM, aniž byste se spoléhali na cloudové služby (které jsou propojeny s Čínou, ať už si o tom uděláte cokoli), a nabízí více soukromí a potenciální svobody přizpůsobit a doladit model pro vaše konkrétní případy použití.

Abyste mohli lokálně spouštět DeepSeek, musíte mít Apple Silicon Mac. V tomto případě použijeme bezplatný nástroj pro Mac s názvem LM Studio, abychom mohli rychle nastavit a používat DeepSeek na Macu. I když to všechno zní složitě a AI a technologie LLM mohou být pro nováčky ohromující, tento proces nastavení je opravdu docela snadný, protože vás tím provedeme.

Opět musíte mít Apple Silicon Mac s čipem M-series nebo lepším, abyste mohli spouštět DeepSeek lokálně. I když je tento softwarový požadavek přísný, je také standardem pro provoz jakéhokoli jiného místního modelu, včetně Apple Intelligence, ChatGPT, Llama nebo jakýchkoli dalších stále běžnějších nástrojů LLM. Budete také chtít alespoň 10 GB volného místa na disku. Pokud nemáte Apple Silicon Mac, můžete stále používat nástroje AI prostřednictvím svého iPhonu nebo iPadu pomocí různých aplikací nebo jakéhokoli Macu přes web. Pro naše účely zde předpokládáme, že máte Apple Silicon Mac, v takovém případě zde je návod, jak spustit DeekSeek lokálně:

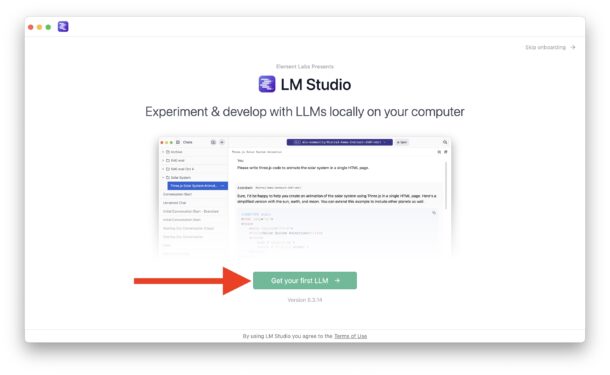

- Získejte zdarma lmstudio z lmstudio.ai

- Připojte obraz disku pro LMStudio a zkopírujte aplikaci „LM Studio“ z obrazu disku do složky Aplikace, abyste ji nainstalovali, a poté spusťte LM Studio přímo ze složky Aplikace.

- Při prvním spuštění se vám zobrazí úvodní obrazovka pro přihlášení, klikněte na zelené tlačítko s nápisem „Získejte svůj první LLM“

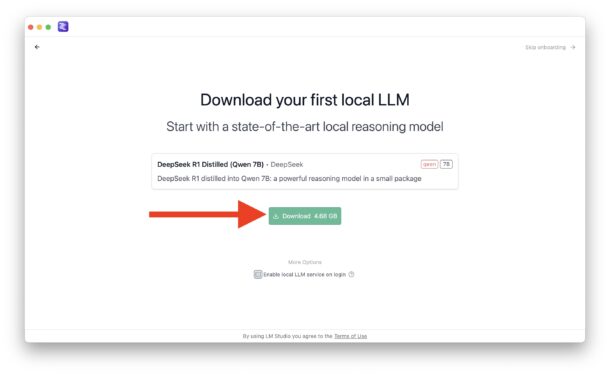

- Na obrazovce stahování první místní LLM klikněte na zelené tlačítko „Stáhnout“ (volitelně zrušte zaškrtnutí políčka „Povolit místní službu LLM při přihlášení“, pokud nechcete, aby se pro DeekSeek spouštěl démon při každém spuštění počítače Mac)

- Nechte stáhnout DeekSeek LLM, má několik GB a může to chvíli trvat, jakmile se DeekSeek stáhne lokálně, budete připraveni s ním pracovat přímo na vašem Macu

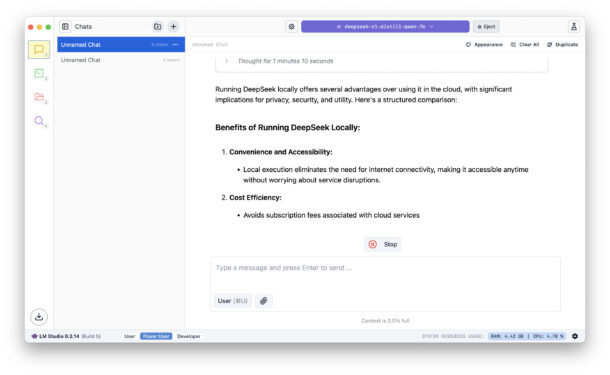

Nyní můžete zdarma používat a interagovat s DeekSeek lokálně na vašem Macu.

Pokud si přejete potvrdit, že vaše zkušenost je zcela místní, vypněte wi-fi nebo se jinak odpojte od internetu a uvidíte, že s LM Studio a DeekSeek můžete stále komunikovat, jak chcete.

Doporučené čtení:Vždy otevírat místně uložené soubory Office 365 namísto OneDrive ve Windows 10

Pravděpodobně si všimnete toho, že spouštění libovolného LLM lokálně bude pravděpodobně pomalejší než používání cloudového LLM, a to proto, že cloudové LLM mají obrovské množství výkonných zdrojů vyhrazených výhradně pro provoz modelů, zatímco když LLM provozujete lokálně, bude omezeno místními zdroji vašeho Macu, včetně vašeho procesoru, paměti a čeho dalšího běží na vašem Macu. Pokud vás zajímá výhradně rychlost a výkon, pravděpodobně budete chtít místo toho použít poskytovatele cloudu, i když nejnovější nejvýkonnější počítače Mac jsou také poměrně rychlé.

Můžete také použít LM Studio na Macu ke spuštění dalších LLM lokálně, kromě DeekSeek to zahrnuje Llama, Mistral a Phi, ale zde se samozřejmě zaměřujeme na DeepSeek. V minulosti jsme diskutovali o dalších možnostech v souladu s místními modely, včetně spuštění Llama LLM lokálně na Macu (včetně necenzurovaného modelu!), ale tento přístup k místnímu spuštění DeepSeek (a dalších LLM, pokud jste zvědaví) je opravdu docela snadný a výkon je také dobrý. DíkyCultOfMacpro inspiraci.

Osobně jsem velkým fanouškem Mac klienta pro ChatGPT, který často používám, ale je tu také Perplexity a mnoho dalších zajímavých klientů a nástrojů AI. To je kromě desítek možností založených na webu nebo aplikacích, včetně Bing s ChatGPT, Google Gemini, X's Grok, Facebook's Llama a mnoha dalších.

Co si myslíte o spuštění DeepSeek lokálně na vašem Macu? Co si myslíte o LLM a nástrojích AI obecně? Máte preferovaného místního LLM nebo preferovaného LLM klienta? Podělte se o své myšlenky a zkušenosti s DeekSeek, LLM a AI obecně v komentářích!